Російська пропаганда підробила репортаж Deutsche Welle про втрати Сил оборони України

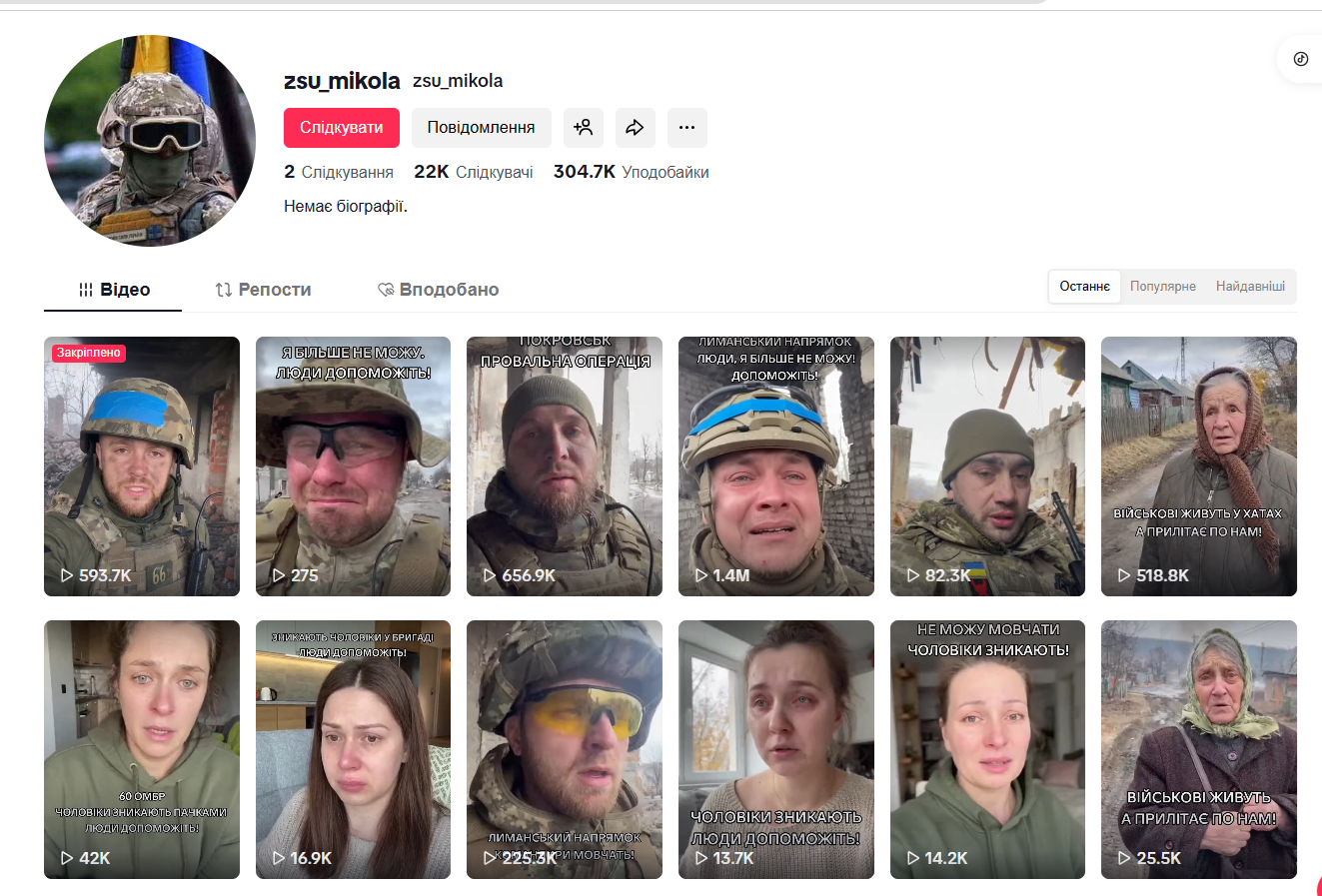

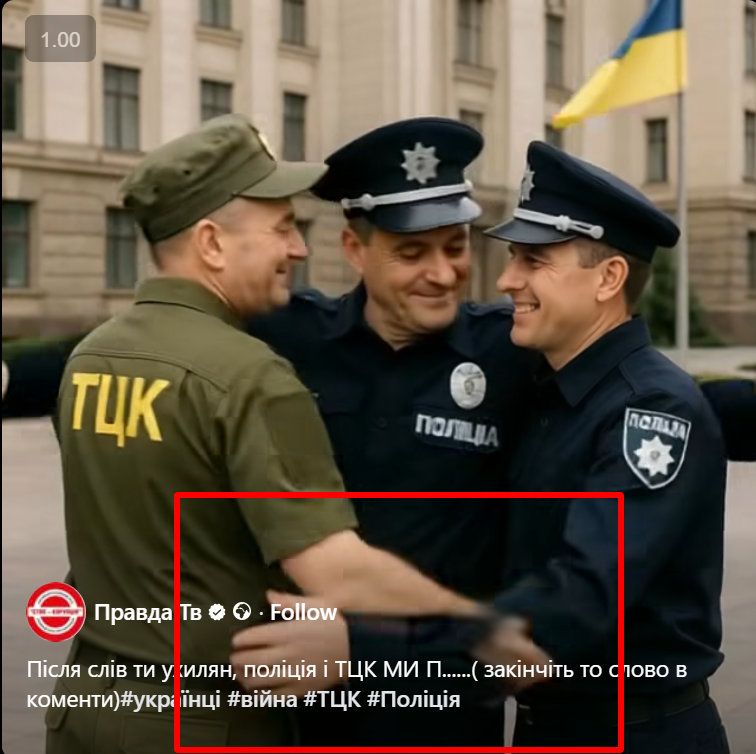

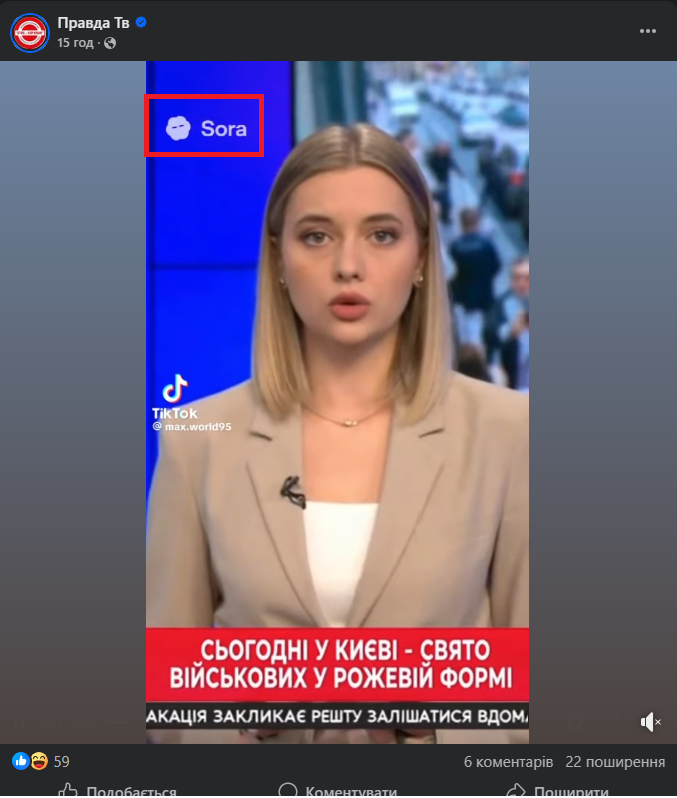

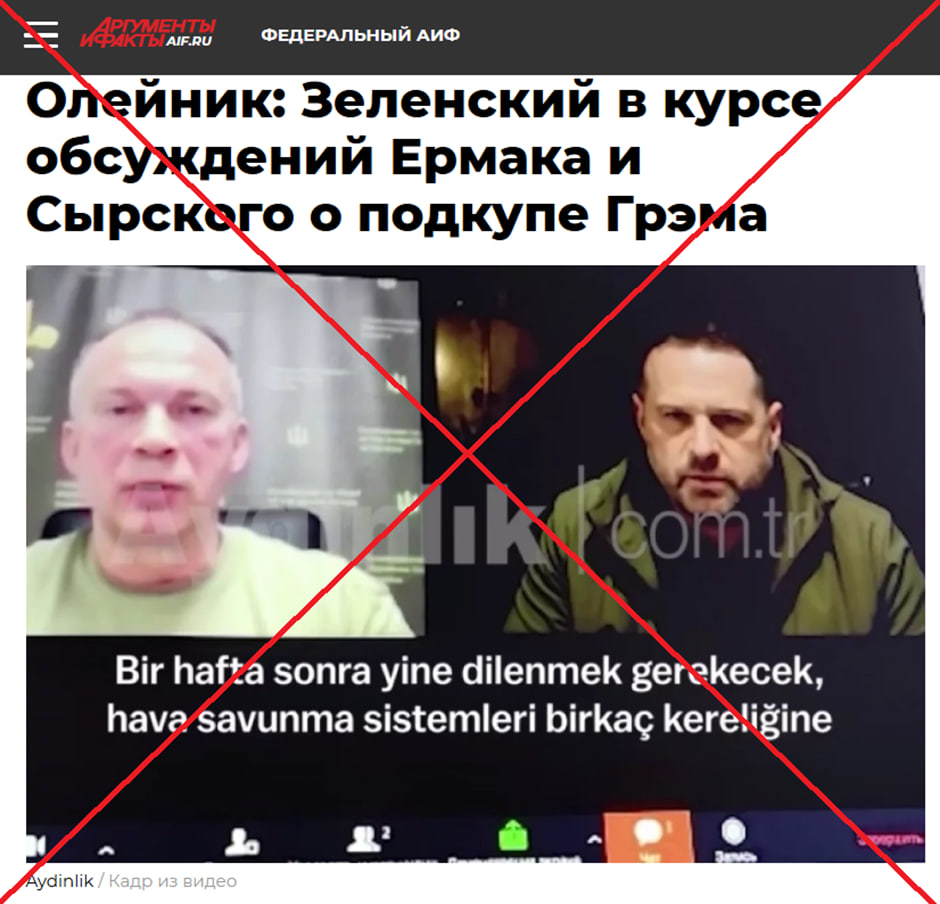

Російські пропагандистські ресурси розпочали масоване поширення фальшивого відеосюжету, який видають за репортаж німецького мовника Deutsche Welle. У підробленому ролику стверджується, нібито військові втрати України сягнули приголомшливої цифри у два мільйони осіб, що є свідомою дезінформацією. Зловмисники використали реальний відеоряд німецького видання, але за допомогою монтажу змінили закадровий текст, додавши вигадані дані про кількість ідентифікованих та невідомих загиблих. Метою такої атаки є поширення паніки, деморалізація українського суспільства та створення ілюзії критичного виснаження української армії. Чому це фейк, розповіли StopFake.

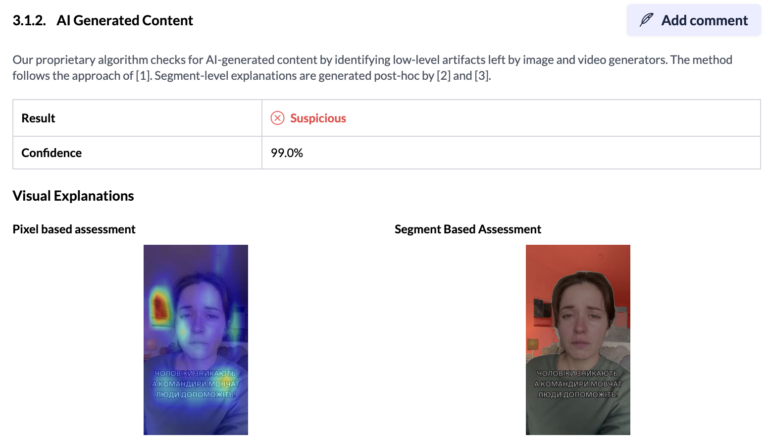

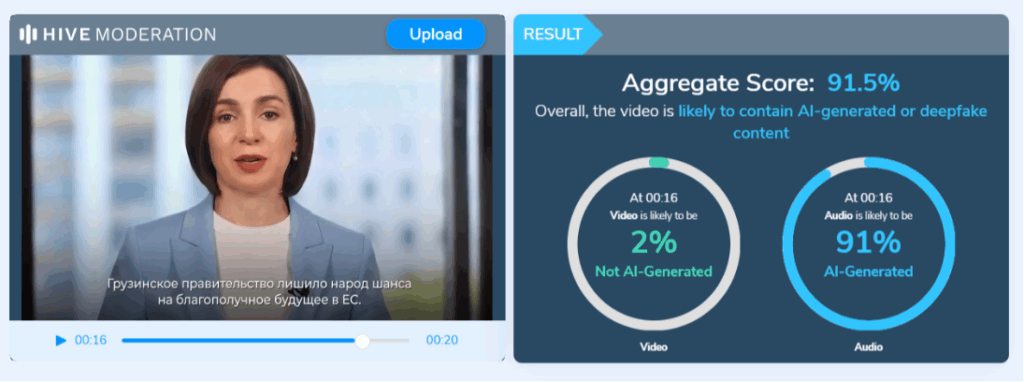

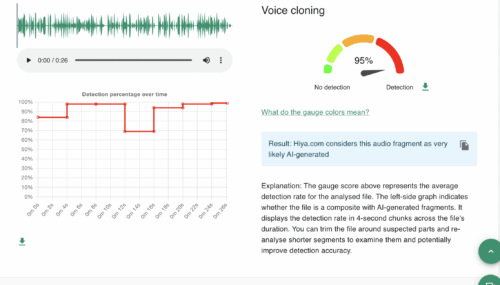

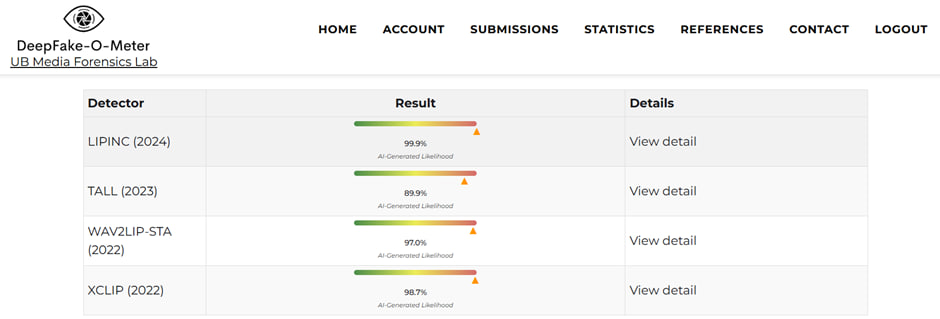

Викрити підробку вдалося завдяки порівнянню розповсюджуваного відео з оригінальним матеріалом Deutsche Welle, який вийшов 2 лютого 2026 року. Справжній репортаж присвячений роботі судових медиків в Одесі та процесу ідентифікації тіл, повернутих із Росії, проте він не містить жодних згадок про загальну кількість втрат ЗСУ. У підробці лише перші тридцять три секунди збігаються з оригіналом, після чого вставлено фальсифікований двадцятисекундний уривок. Уважний аналіз дає змогу почути різку зміну тембру закадрового голосу на місці склейки, а коментарі медичних експертів, наявні у справжньому сюжеті, у фейковій версії повністю видалені або перекриті вигаданим текстом.

Окрім технічних невідповідностей, маніпулятивність новини підтверджується офіційними даними та оцінками міжнародних аналітичних центрів, які суттєво відрізняються від пропагандистських вигадок. На початку 2026 року президент України озвучив цифру у п'ятдесят п'ять тисяч загиблих військовослужбовців, не враховуючи зниклих безвісти. Водночас експерти Центру стратегічних та міжнародних досліджень оцінюють втрати у межах від ста до ста сорока тисяч осіб за весь час повномасштабного вторгнення. Створення відео-двійників іноземних медіа залишається улюбленим інструментом Кремля, оскільки авторитетний бренд західного ЗМІ допомагає надавати неправдивій інформації вигляду достовірності.