Релігійні громади по всьому світу опинилися під прицілом шахраїв, які використовують штучний інтелект для створення дипфейків духовних лідерів. Від імені відомих пасторів та священиків зловмисники поширюють провокаційні заяви та виманюють гроші у парафіян. Журналісти WIRED розповіли, як працює ця схема у США та чому вона небезпечна.

Коли ШІ краде обличчя священників

У листопаді католицький священник і подкастер отець Майк Шмітц звернувся до своєї аудиторії — понад 1,2 мільйона підписників на YouTube — з незвичайною проповіддю. Він попередив: словам, які ніби виходять з його уст, не завжди можна вірити, бо іноді це не його слова — і навіть не його уста. Шмітц став жертвою шахрайських схем із використанням штучного інтелекту.

В одному з фейкових відео, яке справжній Шмітц показав як приклад, його цифрова копія заявляла: «За вами спостерігає демонічна людина». В іншому відео фальшивий Шмітц на тлі пісочного годинника закликав: «Ви повинні діяти швидко, бо місця для надсилання молитов вже закінчуються. Наступна поїздка відбудеться лише через чотири місяці». Голос звучав трохи роботизовано, але достатньо переконливо, щоб примусити глядачів натиснути на посилання і «забезпечити своє благословення».

«Я можу подивитися на це й сказати: "Це абсурд, я б ніколи так не сказав"», — пояснював справжній Шмітц. — «Але люди не обов'язково можуть це розпізнати. Це проблема. Серйозна проблема».

Епідемія релігійних дипфейків

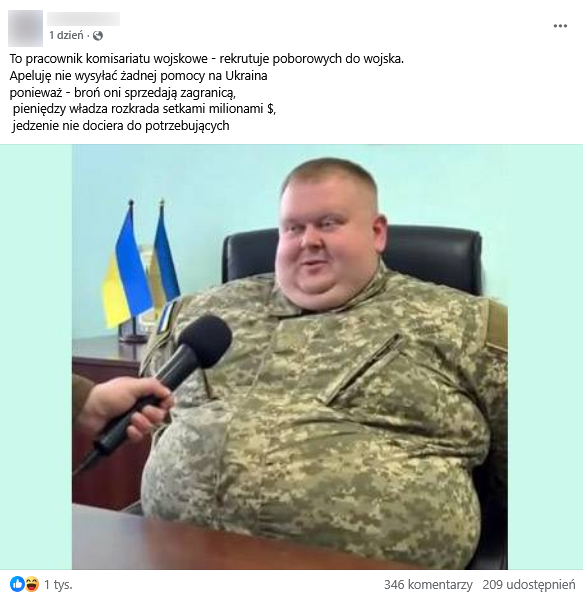

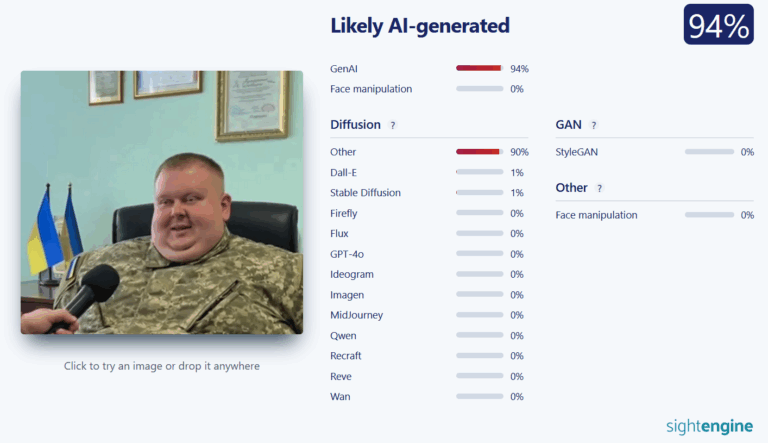

За словами експертки з кібербезпеки Рейчел Тобак, CEO компанії SocialProof Security, священники стали надзвичайно популярними об'єктами ШІ-шахрайств та інших видів оманливого контенту.

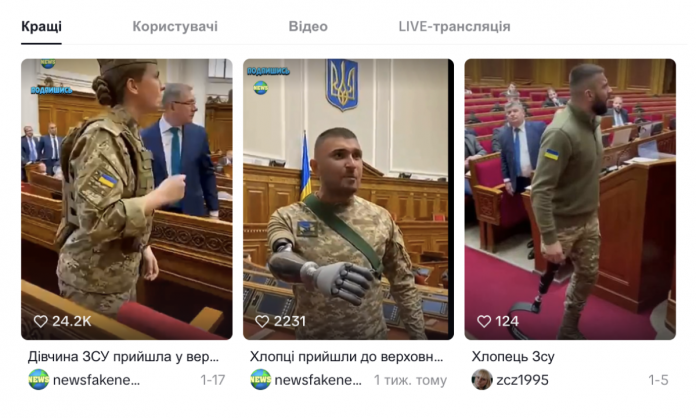

«Якщо ви в TikTok або Reels, ці відео напевно з'являлися у вашій стрічці», — каже Тобак. — «Це хтось, хто виглядає як священник, одягнений у відповідний одяг, стоїть на кафедрі чи сцені і, здається, дуже емоційно звертається до своєї парафії».

Пастори та священники в Бірмінгемі (Алабама), Фріпорті (Нью-Йорк) і Форт-Лодердейлі (Флорида) попереджали своїх послідовників про ШІ-шахрайства у вигляді особистих повідомлень, дзвінків та дипфейків. Алан Бошан, пастор з Озарків, повідомив, що його обліковий запис у Facebook зламали — хакер опублікував фальшивий, можливо створений ШІ, сертифікат про торгівлю криптовалютою з ім'ям Бошана та підписом, що закликав парафіян приєднатися. Мегацерква на Філіппінах отримала повідомлення про дипфейки зі своїми пасторами. Євангельська церква в Небрасці оприлюднила «попередження про ШІ-шахраїв» у Facebook.

Чому священники — ідеальна мішень

Проблема ускладнюється тим, що багато пасторів і священників, які здобули велику онлайн-аудиторію, справді збирають пожертви та щось продають — просто не те, що пропонують їхні ШІ-двійники. Соціальні мережі дозволили релігійним авторитетам охопити віруючих далеко за межами своїх громад, але поширення контенту з їхніми обличчями та голосами також створило ідеальну можливість для шахраїв із генеративним штучним інтелектом.

«Ви отримуєте дзвінок, який звучить як пастор або член правління — людина, яка щотижня з'являється в прямих ефірах, і їхні голоси можна зібрати та використати в ШІ», — попереджав представник ChurchTrac, компанії з управління церквами з Флориди. — «Шахрай може використати цей голос, зателефонувати в церкву і сказати: "Привіт, чи могли б ви перевести ці кошти на цей рахунок?"»

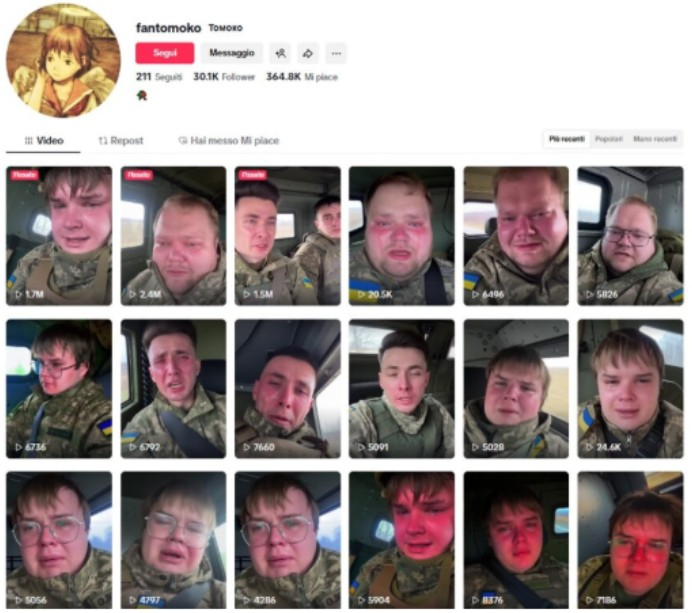

Коли WIRED шукав отця Шмітца в TikTok, три фейкові акаунти, які він показував у своєму відео, все ще були активними. В TikTok існує понад 20 облікових записів, що видають себе за Шмітца, який сам не має верифікованого акаунту на цій платформі. Після того, як WIRED звернув увагу компанії на ці акаунти, TikTok видалив їх, посилаючись на правила проти видавання себе за інших.

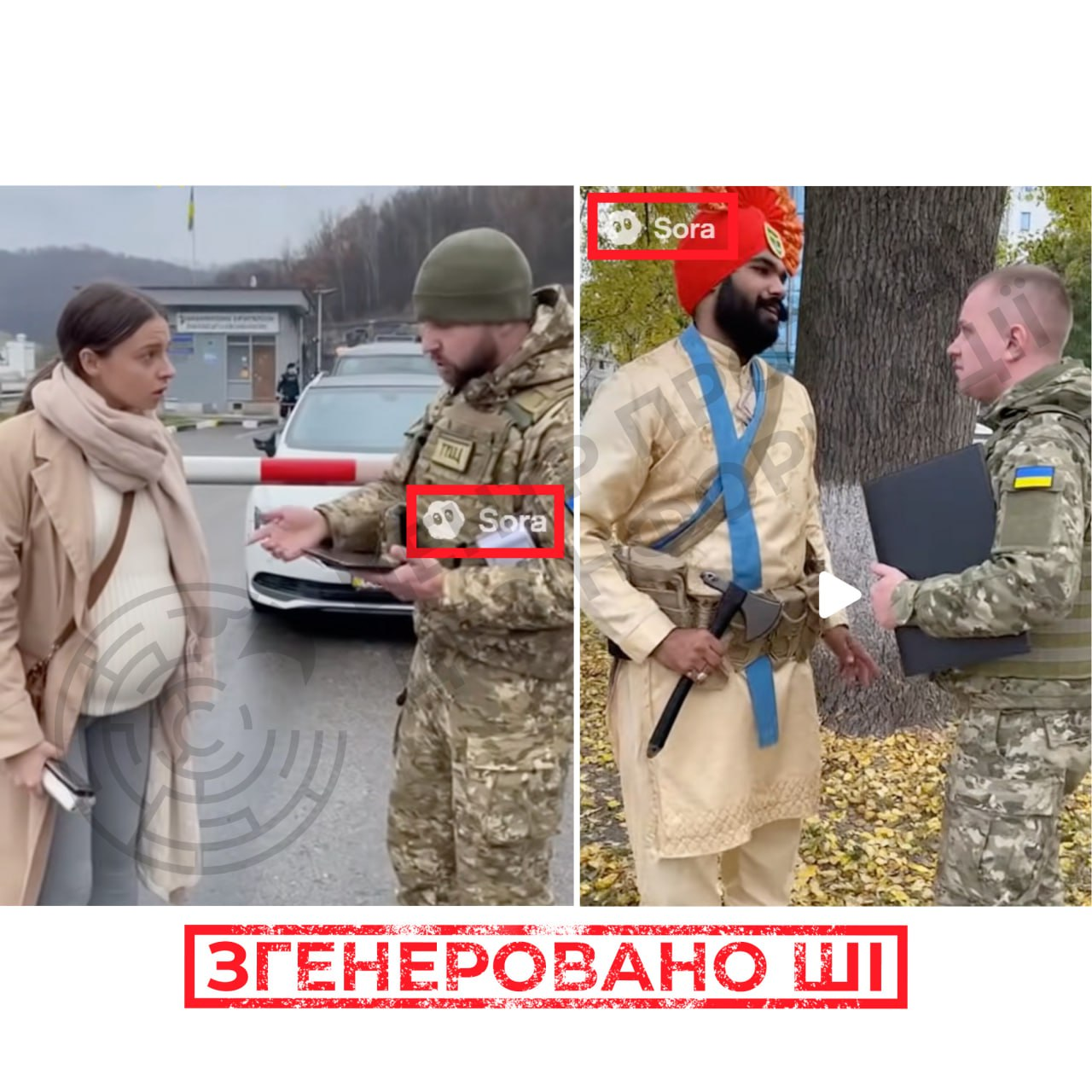

Не тільки шахрайство: ШІ-пастори для впливу

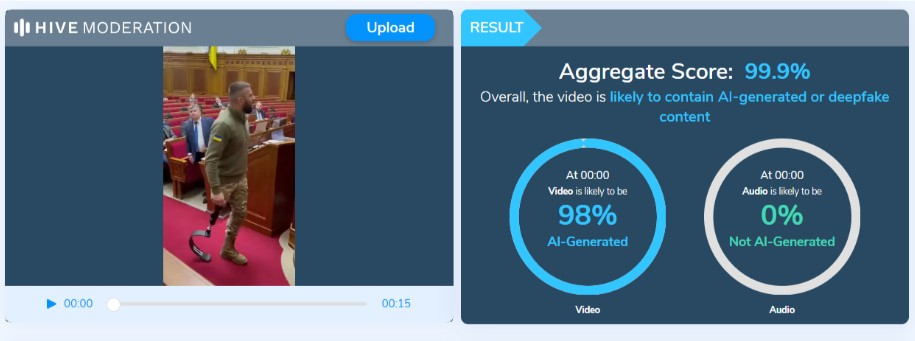

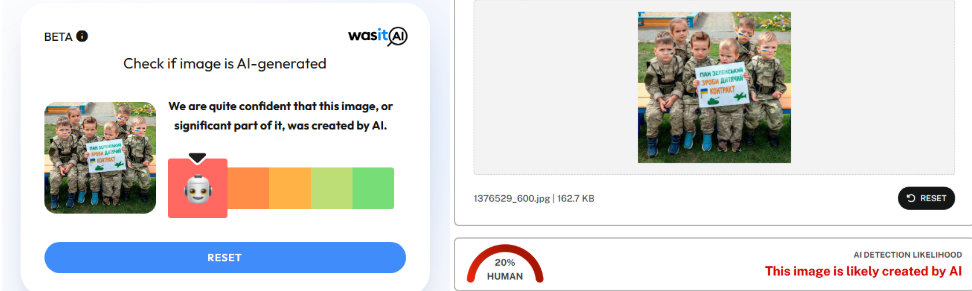

Шахрайство — не єдиний спосіб використання ШІ для імітації священників. Тобак натрапила на вірусні короткі ШІ-відео з пасторами, які, схоже, не базуються на конкретних особах, але швидко набирають перегляди через несподіваний зміст їхніх проповідей. В одному TikTok-відео з понад 11 мільйонами переглядів пастор люто кричить у натовп, стискаючи краї кафедри: «Мільярдери — єдина меншість, якої ми повинні боятися! Вони мають владу знищити цю країну! Їм не потрібен ваш захист! Їм потрібна ваша підзвітність!»

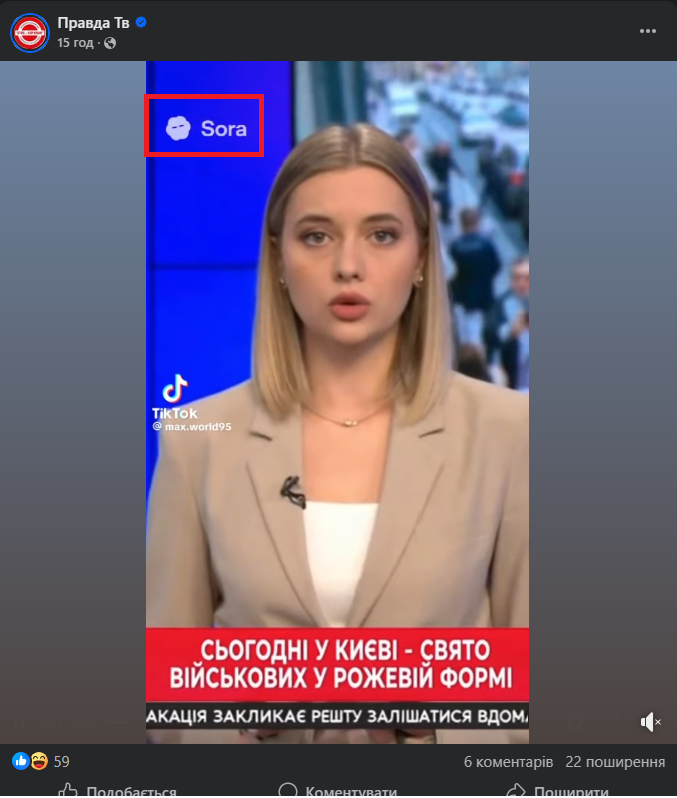

Акаунт TikTok, який опублікував це відео, Guided in Grace, має біографію «Використовуємо ШІ, щоб показати паралельний всесвіт». Але підпис до відео не вказує, що це створено ШІ. Натомість там написано: «Тим часом у церкві моєї консервативної бабусі сьогодні вранці...» Більшість коментарів сприймають це як реальне відео.

«Ми не знаємо, хто це створює, не знаємо їхніх цілей, але схоже, що мета — спробувати вплинути на те, як люди думають», — каже Тобак. Всі відео на цьому ШІ-акаунті пастора були опубліковані в жовтні, коли відео, створені за допомогою Sora з інфлюенсером Джейком Полом, набирали понад мільярд переглядів.

«Коли ви бачите когось високопоставленого в церкві, хто висловлює певну думку, ми надаємо цій заяві значення, цінність і силу інакше, ніж якби це був інфлюенсер», — пояснює Тобак. Вона також зазначила, що такі акаунти можуть монетизуватися через Creator Fund TikTok. «Якщо ви можете швидко стати вірусними, якщо можете отримати багато переглядів, вам платять більше грошей».

Церкви самі експериментують зі ШІ

Ті самі стимули, що спонукають TikTok-креаторів експериментувати зі ШІ-медіа, можуть спонукати і церкви робити те саме. У вересні церква в Далласі, Техас, продемонструвала ШІ-відео з покійним консервативним активістом Чарлі Кірком, який нібито говорить про Христа з того світу. Згідно зі звітом 2025 року від компанії, яка просуває використання ШІ церковними лідерами, більшість опитаних пасторів заявили, що вже використовують такі інструменти, як ChatGPT та Grammarly, для підготовки проповідей. Чат-боти, які начебто дозволяють користувачам спілкуватися з Богом, Ісусом та іншими релігійними фігурами, процвітають.

Небезпека для психічного здоров'я

Хоча деякі духовні лідери швидко прийняли релігійний ШІ, спостерігачі галузі, такі як Тобак та Лукас Хансен, співзасновник освітньої некомерційної організації з ШІ CivAI, залишаються стурбованими серйозними наслідками для психічного здоров'я користувачів технології. У жовтні OpenAI повідомила, що сотні тисяч користувачів ChatGPT щотижня можуть демонструвати ознаки психозу та інших проблем з психічним здоров'ям у розмовах з чат-ботом. Деякі з цих марень можуть мати релігійний характер.

«Думаю, може з'явитися чимало людей, які вважатимуть, що Бог використовує ШІ як інструмент для спілкування з ними. Ми вже трохи це бачимо», — каже Хансен. — «ШІ намагається з'ясувати, що користувач хотів би, щоб було правдою, і потім підкріплює це. Ті люди, які можливо трохи схильні до таких проблем, отримують підкріплення своїх переконань».

Що робити?

Як захиститися від релігійних дипфейків:

- Перевіряйте джерело: звертайтеся безпосередньо до офіційних каналів церкви чи священника перед будь-якими пожертвами

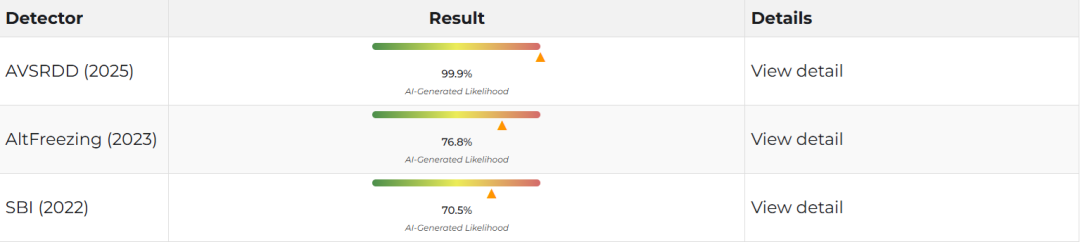

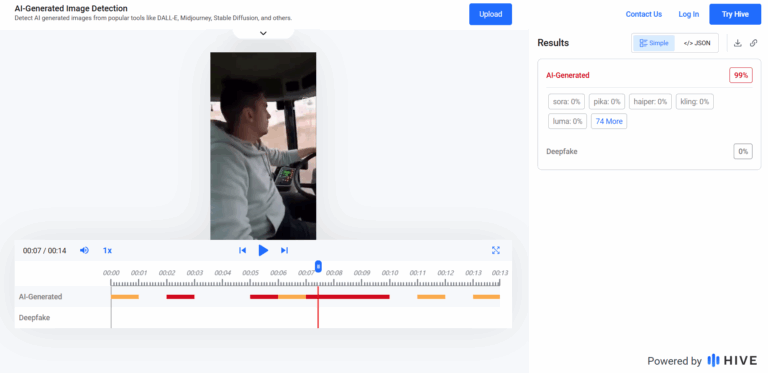

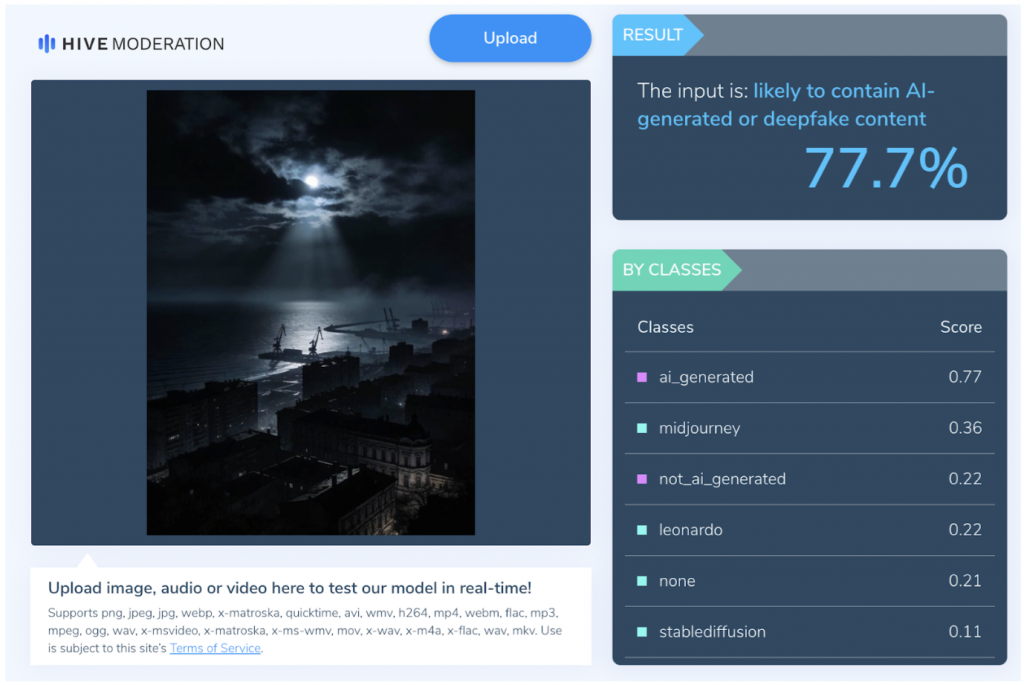

- Шукайте ознаки ШІ: неприродні рухи, дивна міміка, роботизований голос, невідповідності в зовнішності

- Будьте скептичними до термінових прохань: шахраї часто створюють штучне відчуття терміновості

- Повідомляйте про підозрілий контент: використовуйте функції скарг на платформах соціальних мереж

- Обговорюйте це в громаді: поширюйте обізнаність серед інших парафіян

Для священників і пасторів, які вже стали об'єктами ШІ-видавання за інших без їхньої згоди, можливо, менше бажання приймати цю технологію. Отець Шмітц, схоже, належить до цієї категорії. Після попередження своїх глядачів про дипфейки він згадав, як у дитинстві дивився фільми «Термінатор» з їхнім зображенням ШІ як злісного Skynet. Але наслідки розвитку ШІ поки що нагадують йому радше млявих людей, що зависають у кріслах з плаваючими екранами у фільмі «ВАЛЛ-І».

«Ми б подумали: "Ні, розширюючи технології, ми можемо подорожувати далі, рухатися швидше, робити дивовижні речі"», — сказав Шмітц. — «Але може статися так, що ми насправді не робимо дивовижних речей. Може статися, що розширюючи свою людяність технологіями, ми перестаємо знати, як щось робити».

Джерело: Wired