Фейк: Відео з «обуреним військовим» у Верховній Раді виявилося продуктом ШІ

На відео чоловік у військовій формі з ампутацією нібито прийшов до Верховної Ради, щоб висловити претензії народним депутатам. Проте аналіз показав, що це відео це ШІ фейк, створена за допомогою нейромереж. Фальшиве відео розвінчали грузинські фактчекери з mythdetector.

На початку січня проросійські та ботоподібні акаунти у Facebook, а також акаунти у Тіктоці почали поширювати ролик, де військовий із протезом замість ноги емоційно звертається до невідомої особи в кулуарах парламенту. Головний посил відео: «Я втратив ногу, щоб ви тут сиділи».

Ролик супроводжувався підписами, що мають на меті деморалізацію українців та посилення недовіри до державних інституцій.

Чому це фейк: Технічні докази

Фахівці грузинського ресурсу Myth Detector провели детальний розбір відео та виявили численні ознаки використання генеративного штучного інтелекту (ШI).

Візуальні аномалії: При детальному перегляді помітно характерні для нейромереж помилки рендерингу. У деяких кадрах пальці та частини рук «героя» розмиваються, зникають, а потім з’являються знову. Такі дефекти виникають, коли алгоритми ШІ не можуть коректно відтворити складну анатомію руху. Також, трибуна верховної Ради знаходиться далі від рядів крісел, ніж це зображено на відео, а інтер'єр та конфігурація стін справжньої сесійної зали не відповідають зображеному у фейковому ролику.

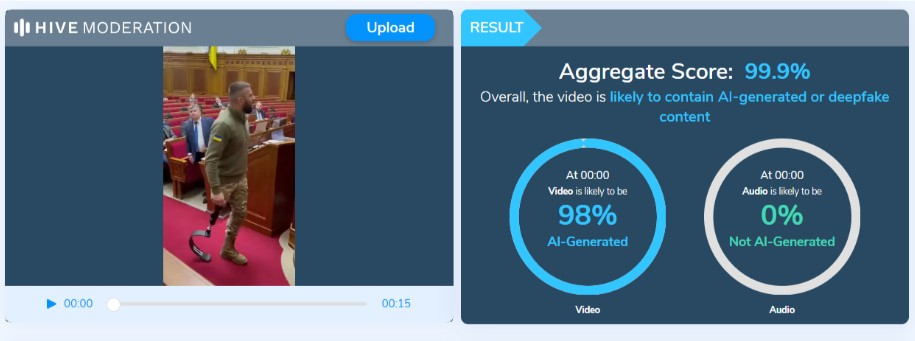

Інструментальна перевірка: Аналіз за допомогою спеціалізованої платформи Hive Moderation показав критично високу ймовірність підробки — 98%. Це підтверджує, що і візуальний ряд, і аудіодоріжка були згенеровані штучно.

Відсутність офіційних свідчень: Жодне авторитетне медіа або офіційне джерело не зафіксувало подібного інциденту у Верховній Раді. Поява військових у залі засідань чи кулуарах, тим паче із виразним публічним конфліктом, стала би подією, яка детально висвітлюється журналістами.

Першоджерелом ролику, ймовірно, був TikTok-акаунт під назвою 0001.kkkkk. На цей час сторінка вже видалена, що є типовою стратегією для «ферм фейків»: створити віральний контент, дочекатися його поширення іншими ресурсами та оперативно зникнути, щоб уникнути блокування за дезінформацію. Втім за подібним запитом у Тіктоці можна знайти дублікати цього відео.

Висновок

Перед нами — класичний приклад Deepfake (діпфейку). Технології штучного інтелекту використовуються з метою маніпуляції та розпалювання емоцій на темі втрат на війні.