Остерігайтеся ШІ-«лікарів», що дають медичні поради в тіктоку

Звіт Science Feedback свідчить про те, що акаунти в тіктоку поширюють медичні поради від імені «лікарів», згенерованих штучним інтелектом (ШІ), з метою отримання великої кількості підписників для подальшої монетизації.

Небезпеки медичних порад, згенерованих штучним інтелектом

Численні повідомлення про відео, створені штучним інтелектом, де лікарі надають часто сумнівні поради щодо здоров'я, почали з'являтися у березні 2025 року, коли журнал Rolling Stone висвітлив використання таких відео для продажу неперевірених харчових добавок. У серпні 2025 року CBS News повідомив, що в TikTok з'являються діпфейки лікарів.

У січні 2026 розслідування видання Indicator виявило десятки аккаунтів, які публікують відео «лікарів», згенерованих штучним інтелектом (ШІ), при чому переважна більшість ідентифікованих аккаунтів були в Instagram, Facebook та Threads.

Журналісти Indicator виявили, що деякі з цих аккаунтів продавали товари для здоров'я та електронні книги, що свідчить про те, що діячі, що стоять за ними, були мотивовані фінансовою вигодою. У звіті Indicator також підкреслено, що дезінформація про здоров'я виглядає більш достовірною, коли її поширює реалістична на вигляд людина, одягнена як медичний працівник. Більше того, це явище поширюється багатьма мовами. Польські фактчекери Demagog писали, що публікації з образами лікарів, згенеровані штучним інтелектом, використовувалися для продажу популярної харчової добавки під назвою шиладжит. Жодних достовірних наукових доказів того, що шиладжит клінічно корисний для лікування захворювань, немає.

Зовсім нещодавно Science Feedback опублікували звіт, у якому розкривається, як франкомовні канали YouTube видають себе за медичних працівників, іноді використовуючи імена справжніх лікарів, що ще більше вводить глядачів в оману. Деякі з цих каналів, схоже, були орієнтовані на людей похилого віку, групу, яка, за деякими дослідженнями, є більш вразливою до онлайн-дезінформації.

Як було визначено акаунти?

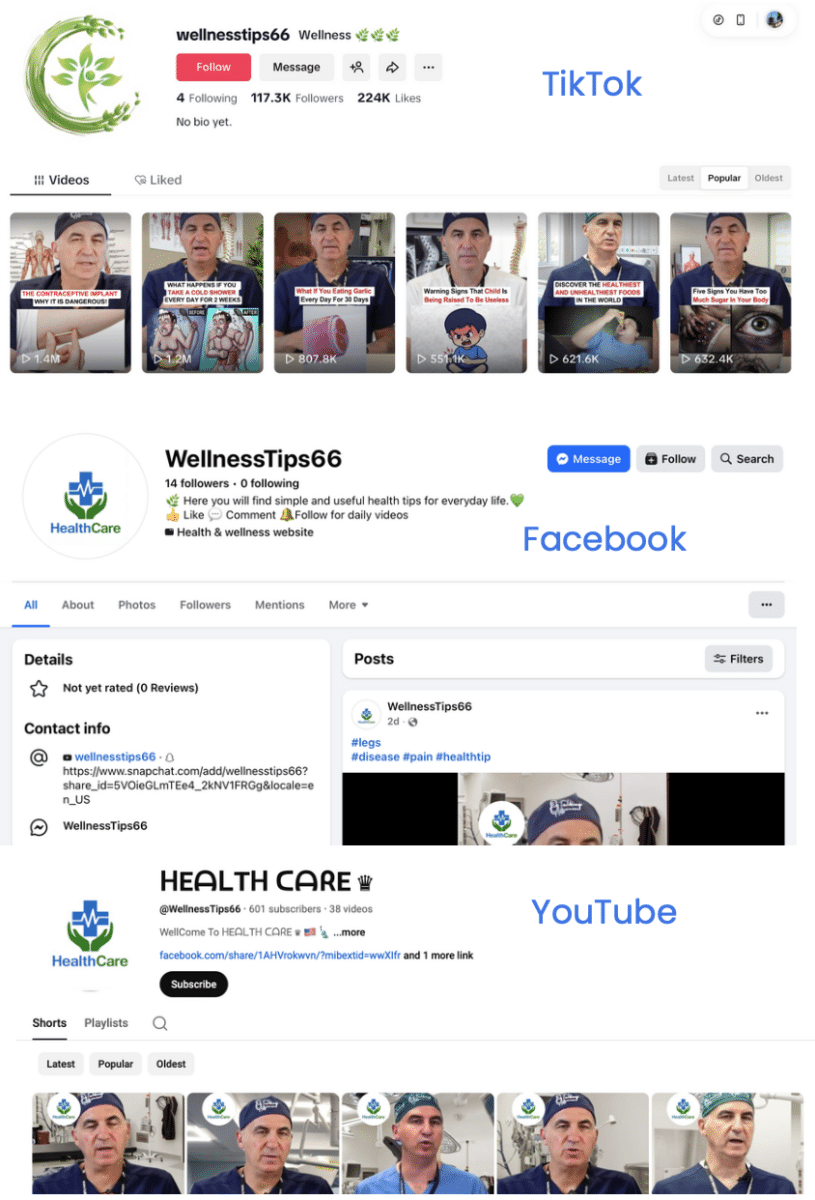

Science Feedback вдалося знайти акаунти, які публікують відео лікарів, створених за допомогою штучного інтелекту, для початкового пошуку в TikTok за терміном «порада лікаря». Це дозволило знайти відповідні публікації та акаунти, які поширювали ці дописи. Після цього команда використала функцію «Пропоновані акаунти» в TikTok, щоб знайти більше схожих акаунтів.

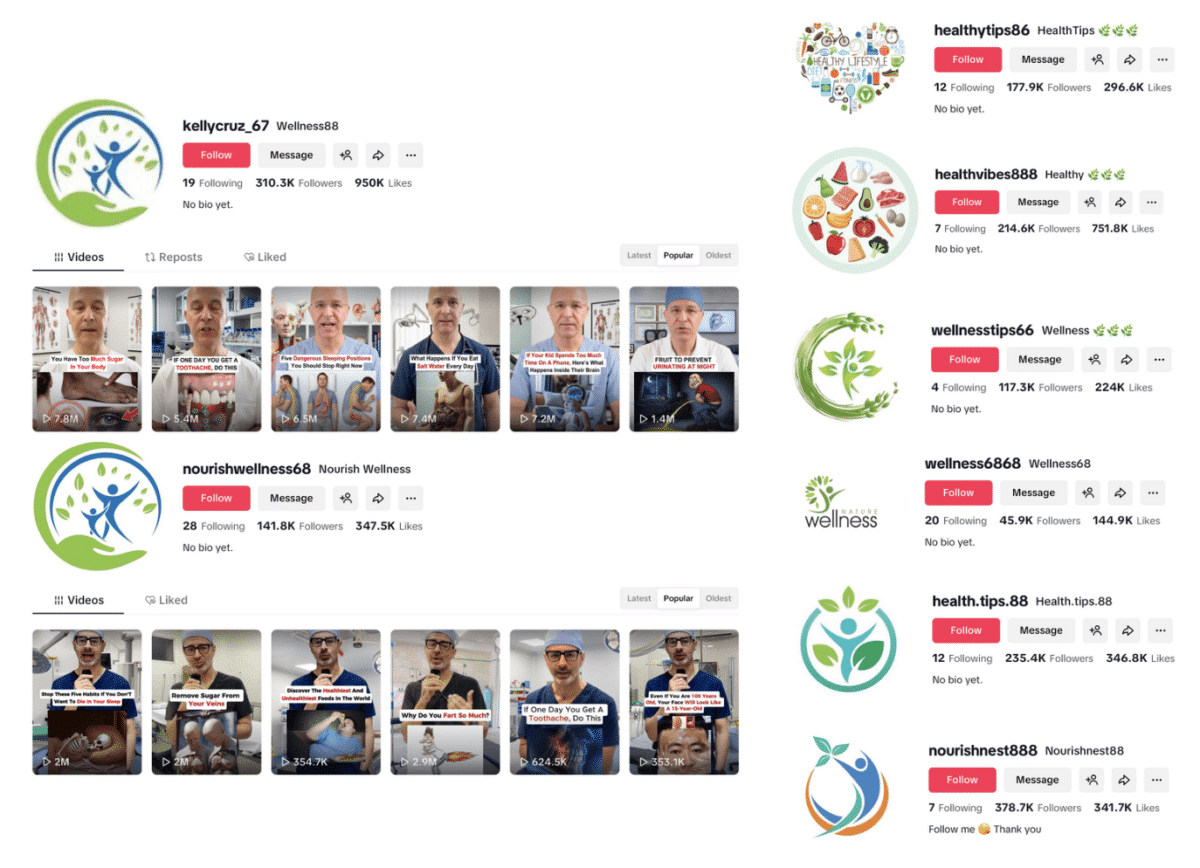

Використовуючи цей метод вдалося ідентифікувати 18 таких акаунтів лише за кілька годин. Час від часу вдалося ідентифікувати пов’язані акаунти соціальних мереж на інших платформах, використовуючи зворотний пошук зображень за фотографією профілю та іменем користувача акаунта TikTok у Google. Кілька знайдених акаунтів мали однакові або схожі фотографії профілів, схожі імена користувачів та схожий дизайн відео.

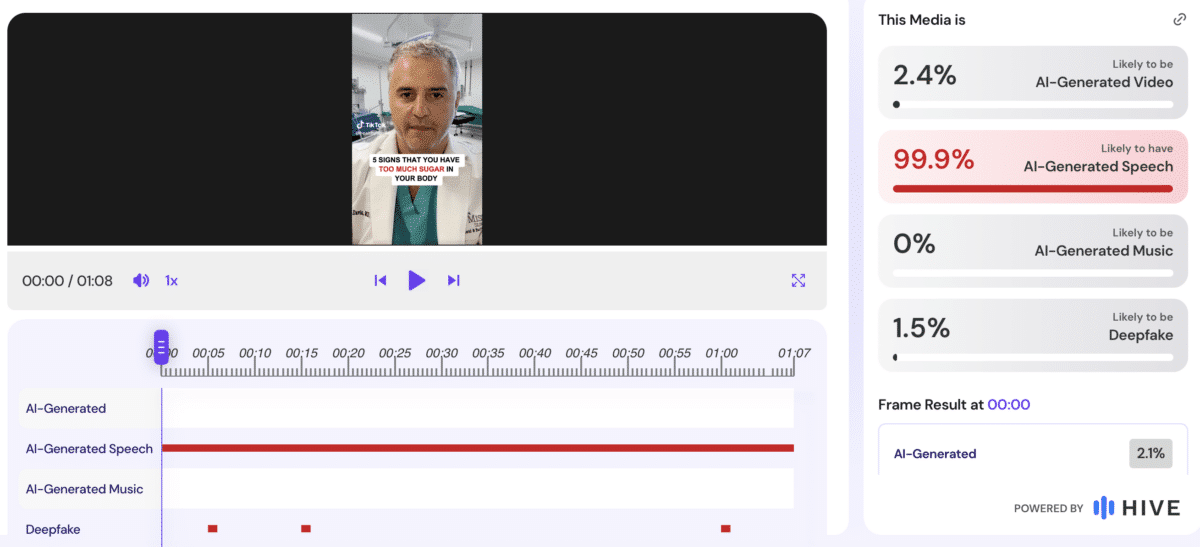

Аналіз відео за допомогою Hive Moderation (інструменту для виявлення контенту, згенерованого штучним інтелектом, та контенту з діпфейками) загалом показав високу ймовірність того, що для створення мовлення у відео використовувався штучний інтелект. Наприклад, відео в TikTok, опубліковане акаунтом @healthytips66 імітує лікаря з питань схуднення Гарта Девіса, який стверджує, що поганий сон та сильна тяга до їжі є ознакою «занадто великої кількості цукру в організмі». Однак такі симптоми неспецифічні, тобто вони пов’язані з багатьма різними станами. Вони не є надійним доказом високого рівня цукру в крові. У іншому відео з TikTokу, опублікованого обліковим записом @health.tips.88. імітовано хірурга-ортопеда Бреда Вінінга, який стверджує, що куркума знижує високий рівень цукру в крові. Деякі дослідження показали, що куркумін, сполука куркуми, може допомогти знизити рівень цукру в крові. Але водночас він не може замінити ліки від діабету.

Дослідникам Science Feedback вдалося ідентифікувати деяких людей, зображених на цих відео, – серед них лікар зі схуднення Гарт Девіс та хірурги-ортопеди Пол Залзал і Бред Вінінг, які ведуть подкаст «Talking With Docs». У свою чергу, «Talking With Docs» дізнався про існування таких акаунтів, попередивши своїх підписників у Facebook про дипфейкові відео їхніх ведучих у січні 2026 року.

Ці акаунти зазвичай не позначали свій контент як створений штучним інтелектом, хоча Правила спільноти TikTok вимагають від творців позначати такий контент. Правила спільноти також «забороняють контент, який може шкідливо вводити в оману або видавати себе за інших», межу, яку ці відео явно перетнули.

Окрім поширення дезінформації про здоров'я, ще однією причиною, яка викликає занепокоєння у цих акаунтах, є їхня здатність залучати велику аудиторію. Більшість із них мали кілька сотень тисяч підписників, а контент, який вони створювали, іноді збирав мільйони переглядів. Наприклад, два найпопулярніші відео, опубліковані акаунтом @healthvibes888, зібрали понад 14 мільйонів переглядів, тоді як акаунт @kellycruz_67 отримав понад сім мільйонів переглядів для деяких своїх відео.

Більшість цих акаунтів не займаються відкритою комерційною діяльністю, як-от продажем добавок, але велика кількість підписників, дає їм право на монетизацію через програму винагород для творців TikTok.

Щоб приєднатися до програми, акаунти повинні відповідати кільком вимогам. По-перше, обліковий запис повинен мати щонайменше 10 000 підписників та 100 000 переглядів відео за останні 30 днів. Інша причина полягає в тому, що відео, які він публікує, повинні тривати більше однієї хвилини.

Кілька знайдених авторами Science Feedback облікових записів багато разів перетнули мінімальний поріг підписників, а це означає, що вони могли мати право на монетизацію через цю програму. Відео, які ми проаналізували, також тривали понад хвилину.

Зрештою, популярність цих відео означає, що вони показуються багатьом користувачам і, ймовірно, спонукають багатьох користувачів підписатися на такі облікові записи. Продаж облікових записів у соціальних мережах з великою кількістю підписників може бути прибутковим, і ці облікові записи є цінними для зловмисників, оскільки їх можна перепрофілювати для різних цілей, наприклад для шахрайських дій в Інтернеті, як повідомляв Indicator у лютому 2026 року.

Це викликає занепокоєння, адже користувачі частіше вірять дезінформації, коли її надає хтось, хто виглядає як експерт, що ускладнює спростування дезінформації. Неточна дезінформація про здоров'я може призвести до фізичної шкоди, а в довгостроковій перспективі вона також може зашкодити довірі до медичних працівників загалом, ще більше підриваючи довіру громадськості до медичної професії.

На основі публікації Science Feedback